Khi quản lý một website, không phải tất cả các trang đều cần được Google thu thập dữ liệu và lập chỉ mục. Có những nội dung bạn muốn ẩn khỏi công cụ tìm kiếm, chẳng hạn như trang quản trị, trang thử nghiệm hoặc dữ liệu nhạy cảm. Đó là lúc tệp robots.txt phát huy tác dụng.

Bạn muốn đẩy nhanh từ khóa lên top Google? Tìm hiểu ngay phần mềm tăng traffic website đang được nhiều SEOer tin dùng để tăng traffic website đưa từ khóa lên top Google nhanh chóng.

Vậy robots.txt là gì? Làm thế nào để sử dụng tệp này một cách hiệu quả để hướng dẫn Googlebot thu thập dữ liệu đúng cách, tránh lập chỉ mục những trang không cần thiết? Trong bài viết này, chúng ta sẽ tìm hiểu cách tạo, cấu hình và sử dụng robots.txt để kiểm soát việc lập chỉ mục, giúp tối ưu hóa SEO và bảo vệ dữ liệu trang web của bạn.

Robots.txt là gì?

Robots.txt là một tệp văn bản đơn giản được đặt trong thư mục gốc của website (ví dụ: https://example.com/robots.txt). Tệp này hoạt động như một “hướng dẫn” cho các bot của công cụ tìm kiếm, cho phép hoặc từ chối quyền truy cập vào các phần cụ thể của trang web.

- Mục đích chính: Kiểm soát việc thu thập dữ liệu (crawling) của các bot.

- Cách hoạt động: Khi một bot truy cập vào website, nó sẽ tìm kiếm tệp Robots.txt đầu tiên để xem liệu nó có được phép truy cập vào các trang cụ thể hay không.

Tại sao Robots.txt lại quan trọng?

Sử dụng Robots.txt đúng cách mang lại nhiều lợi ích cho website của bạn:

Tăng traffic cho website liệu có giúp từ khóa lên top google? Câu trả lời sẽ khiến bạn bất ngờ!

- Bảo vệ tài nguyên: Ngăn chặn việc lập chỉ mục các trang không cần thiết, chẳng hạn như trang quản trị hoặc trang thử nghiệm.

- Tối ưu hóa ngân sách thu thập dữ liệu (Crawl Budget): Giúp các bot tập trung vào các trang quan trọng, tiết kiệm thời gian và tài nguyên.

- Bảo mật thông tin: Hạn chế việc các thông tin nhạy cảm bị lập chỉ mục và hiển thị trên công cụ tìm kiếm.

Cách tạo và sử dụng Robots.txt

1. Cấu trúc cơ bản của Robots.txt

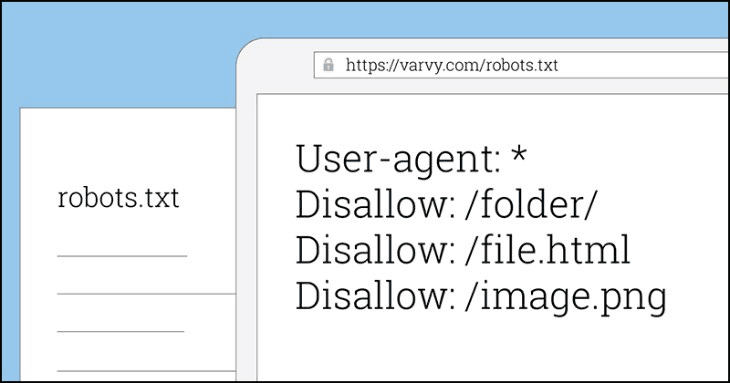

Tệp Robots.txt có cấu trúc đơn giản, bao gồm các dòng lệnh (directives) để chỉ định quyền truy cập cho các bot. Dưới đây là một ví dụ cơ bản:

User-agent: *

Disallow: /private/

Allow: /public/

- User-agent: Xác định bot cụ thể (ví dụ:

*áp dụng cho tất cả các bot). - Disallow: Chỉ định các trang hoặc thư mục mà bot không được phép truy cập.

- Allow: Cho phép bot truy cập vào các trang hoặc thư mục cụ thể.

2. Các lệnh phổ biến trong Robots.txt

- User-agent: Xác định bot mà lệnh áp dụng.

- Ví dụ:

User-agent: Googlebot(chỉ áp dụng cho bot của Google). - Disallow: Chặn bot truy cập vào một trang hoặc thư mục.

- Ví dụ:

Disallow: /admin/(chặn truy cập vào thư mục/admin/). - Allow: Cho phép bot truy cập vào một trang hoặc thư mục.

- Ví dụ:

Allow: /blog/(cho phép truy cập vào thư mục/blog/). - Sitemap: Chỉ định vị trí của tệp sitemap.

- Ví dụ:

Sitemap: https://example.com/sitemap.xml.

3. Ví dụ thực tế về Robots.txt

Dưới đây là một số ví dụ cụ thể về cách sử dụng Robots.txt:

Xem thêm: Cách sử dụng phần mềm tăng traffic website để tăng thứ hạng từ khóa nhanh.

- Chặn tất cả các bot truy cập vào toàn bộ website:

User-agent: *

Disallow: /

- Cho phép tất cả các bot truy cập vào toàn bộ website:

User-agent: *

Disallow:

- Chặn một bot cụ thể (ví dụ: Bingbot) truy cập vào một thư mục:

User-agent: Bingbot

Disallow: /private/

- Cho phép bot của Google truy cập vào tất cả các trang ngoại trừ thư mục

/temp/:

User-agent: Googlebot

Disallow: /temp/Những lưu ý khi sử dụng Robots.txt

- Không sử dụng Robots.txt để ẩn thông tin nhạy cảm: Robots.txt chỉ là một hướng dẫn, không phải là công cụ bảo mật. Nếu bạn muốn ẩn thông tin, hãy sử dụng các phương pháp bảo mật khác như mật khẩu hoặc tường lửa.

- Kiểm tra kỹ trước khi triển khai: Một lỗi nhỏ trong Robots.txt có thể khiến toàn bộ website của bạn không được lập chỉ mục. Sử dụng công cụ kiểm tra Robots.txt của Google Search Console để đảm bảo không có lỗi.

- Kết hợp với meta robots: Nếu bạn muốn kiểm soát việc lập chỉ mục ở cấp độ trang, hãy sử dụng thẻ meta robots trong HTML.

Cách kiểm tra Robots.txt

Để đảm bảo Robots.txt hoạt động đúng cách, bạn có thể sử dụng các công cụ sau:

- Google Search Console: Truy cập vào mục “Robots.txt Tester” để kiểm tra và xác nhận cấu trúc của tệp.

- Công cụ trực tuyến: Sử dụng các công cụ như Screaming Frog hoặc Robots.txt Tester để phân tích tệp.

Kết luận

Robots.txt là một công cụ mạnh mẽ giúp bạn kiểm soát cách các công cụ tìm kiếm truy cập và lập chỉ mục website của mình. Bằng cách sử dụng đúng cách, bạn có thể tối ưu hóa hiệu suất SEO, bảo vệ thông tin nhạy cảm, và tiết kiệm ngân sách thu thập dữ liệu.

Nếu bạn muốn tìm hiểu thêm về các công cụ và kỹ thuật SEO khác, hãy truy cập ngay Softhub.vn để khám phá nhiều thông tin hữu ích và chuyên sâu hơn!

🚀 Muốn tăng traffic tự nhiên cho website một cách an toàn và nhanh chóng? 👉 Xem ngay 5 phương pháp hiệu quả giúp tăng traffic tự nhiên nhanh mà lại an toàn này nhé!